Como criar visuais musicais para sua apresentação ao vivo?

Algumas referências de apresentações ao vivo

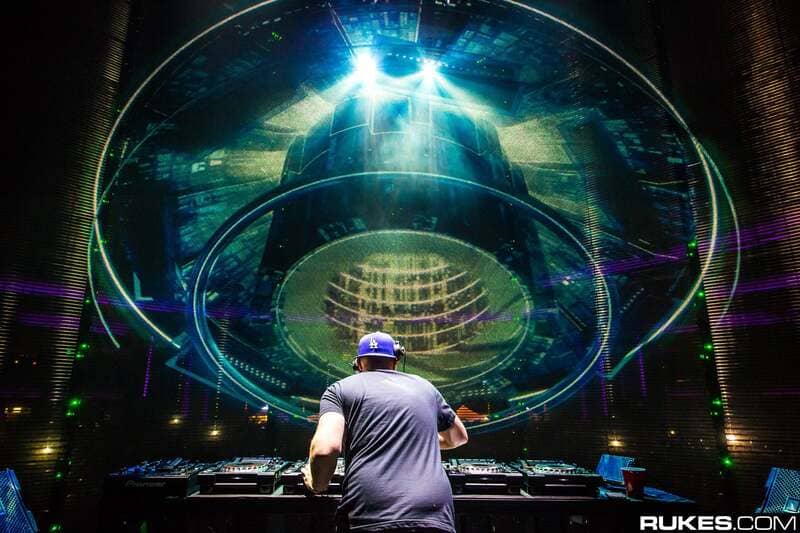

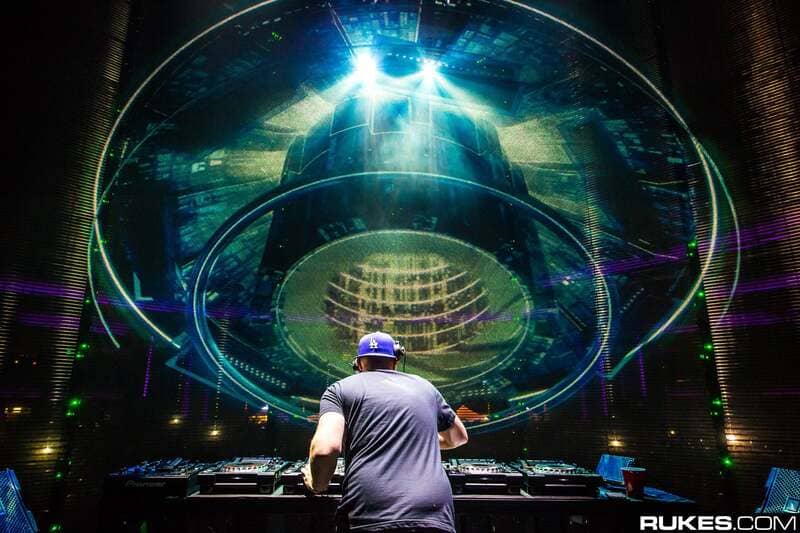

Se você é fã de música eletrônica, provavelmente já notou que cada vez mais artistas e festivais estão se concentrando na decoração do palco. Ela geralmente consiste em elementos de cenário fixos, às vezes combinados com projeção de vídeo e telas de LED. Eventos como Tomorrowland ou Dour Festival são exemplos muito bons. Quanto aos artistas, podemos mencionar, entre os mais famosos, nomes como Amon Tobin, Aphex Twin ou Eric Prydz. Eles foram pioneiros no uso de visuais responsivos à música em um palco de grande escala.

No entanto, a implementação de tais instalações requer longos períodos de design e a colaboração de uma equipe criativa dedicada. De fato, a alta resolução das imagens a serem manipuladas e sua capacidade de reagir à música são problemas complexos a serem resolvidos. Para garantir uma sincronização perfeita entre o som e as imagens durante uma apresentação ao vivo, os tempos de latência devem ser os menores possíveis. Além disso, muitas vezes é necessário usar vários computadores em rede e sincronizá-los entre si. Além das habilidades criativas, há um verdadeiro conhecimento técnico. Todos os processos a serem dominados podem ser agrupados sob o termo de tecnologias de VJ e podem ser divididos em técnicas como computação gráfica, programação, processamento de sinais de áudio e vídeo, gravação ao vivo…

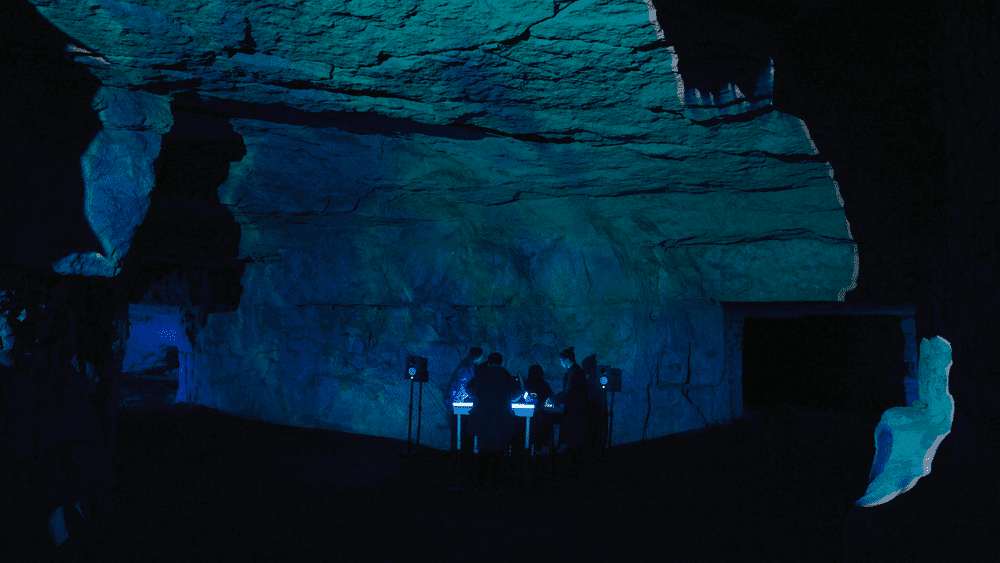

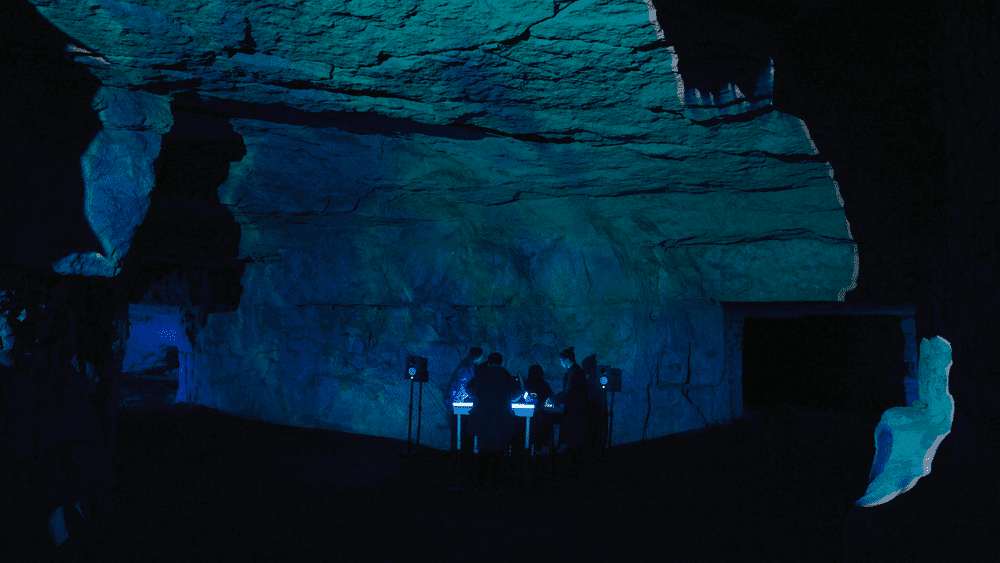

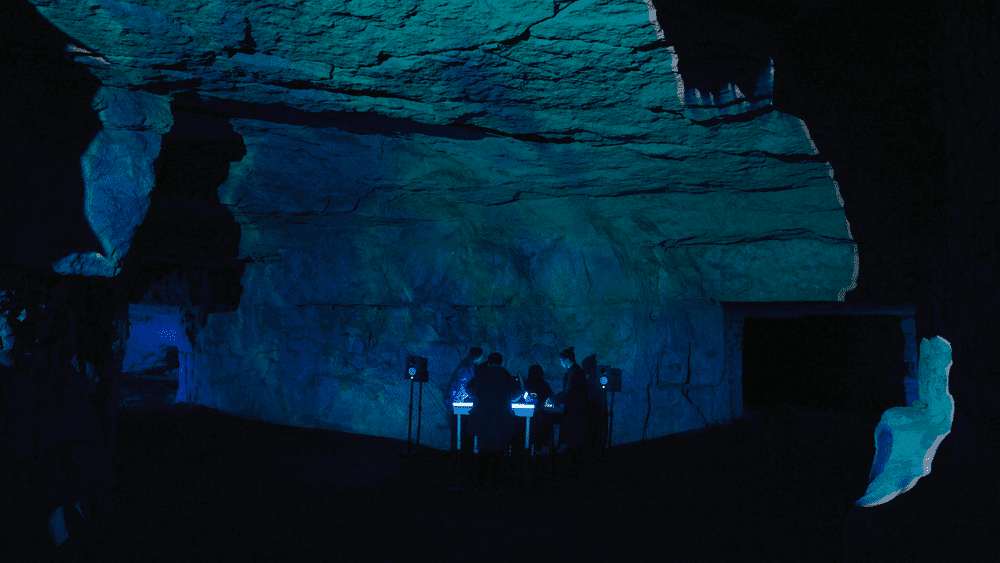

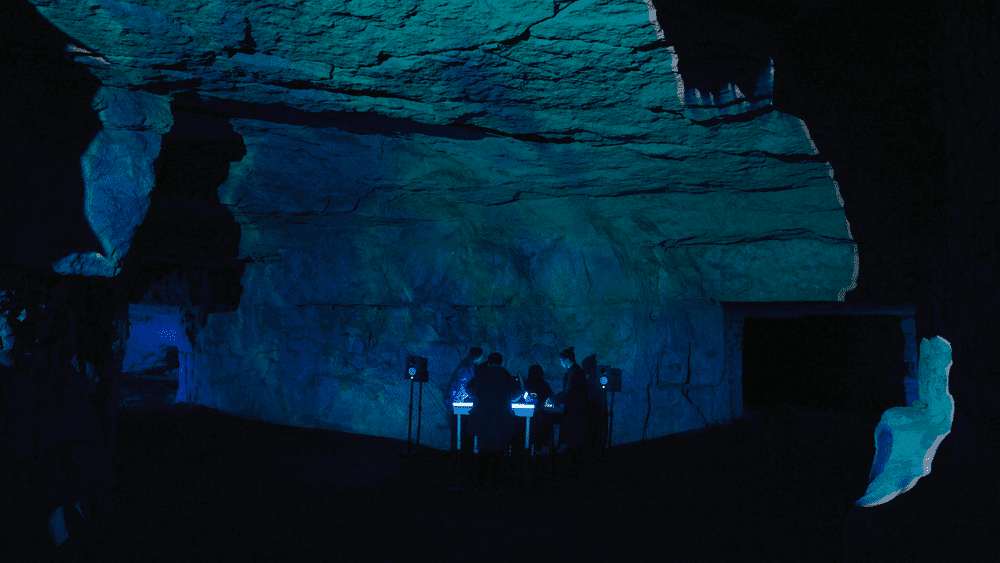

Neste artigo, o objetivo é demonstrar que a criação de visuais responsivos à música para apresentações em palco de pequena e média escala não está tão fora de alcance quanto se poderia pensar. Com software acessível e hardware econômico, é bem possível criar uma apresentação audiovisual ao vivo sem dedicar semanas de trabalho a ela. Para ilustrar esse ponto, os artistas Control Random, Neurotypique, Marin Scart e Jean-Michel Light compartilharam os estágios de concepção de sua última apresentação em uma jazida de calcário.

Pontos de foco para efeitos visuais ao vivo: FPS e latência.

Ao criar visuais responsivos à música para uma apresentação ao vivo, os dois pontos de foco são a fluidez das animações visuais e o latência entre a música e o vídeo.

É absolutamente necessário que as imagens sejam geradas a uma taxa de pelo menos 24 quadros por segundo. Esses dados são chamados de taxa de quadros e são expressos em FPS (frames per second, do inglês). Se você estiver abaixo desse valor, por exemplo, com 12 quadros por segundo, todas as animações parecerão bruscas. No caso de animações rápidas, muitas vezes é necessário buscar um valor acima de 24 FPS: 30 ou até mesmo 60 FPS.

Por exemplo, em videogames com animações muito rápidas , os jogadores preferem a taxa de quadros à resolução para não perder nenhuma ação: melhor experiência com 60 FPS em Full HD do que com 30 FPS em 4K. Portanto, há uma compensação entre melhor resolução e melhor FPS.

Quanto mais o computador for usado para processamento com uso intensivo de recursos, como efeitos visuais ou reprodução simultânea de vários vídeos em HD, mais o número de FPS tenderá a cair. Geralmente, é possível exibir o número de FPS por meio das configurações da placa de vídeo ou do software usado. Cabe a você encontrar o melhor equilíbrio entre a complexidade dos recursos visuais e o limite de FPS abaixo do qual você não deve cair durante a apresentação ao vivo.

Quanto à latência, é o atraso entre uma ocorrência na música e sua repercussão nas imagens. Por exemplo, para cada "batida" na música, você deseja associar um efeito visual de distorção reativa ao áudio. Como regra geral, podemos dizer que dois eventos parecerão instantaneamente vinculados aos seres humanos se o atraso entre eles for inferior a 100 ms. Não há uma regra absoluta com relação ao valor a ser respeitado, mas um atraso maior que 100 ms será considerado perceptível. Quanto mais baixo for o FPS, maior será a latência em seus efeitos visuais responsivos à música.

No caso de um show ou de uma apresentação de DJ, quando a música é tocada ao vivo e não é pré-gravada, ela sempre será dominante em relação às imagens. Não é possível diminuir a velocidade para coincidir com as animações visuais. Portanto, são as imagens que precisam se adaptar para não parecerem fora de sincronia. Ou você reduz os efeitos ativados para não deixar o computador lento ou planeja usar um modelo mais potente.

Uma técnica comum usada por muitos video jockeys (VJs) é dividir o sistema em duas partes: clipes de vídeo pré-renderizados são reproduzidos, misturados e, em seguida, combinados com efeitos visuais reativos ou não à música que são aplicados ao vivo. Em seguida, é necessário que todos os videoclipes usados tenham o mesmo FPS para que o VJ possa ajustar sua velocidade de acordo com a música tocada.

Um exemplo de uma apresentação ao vivo usando visuais reativos à música

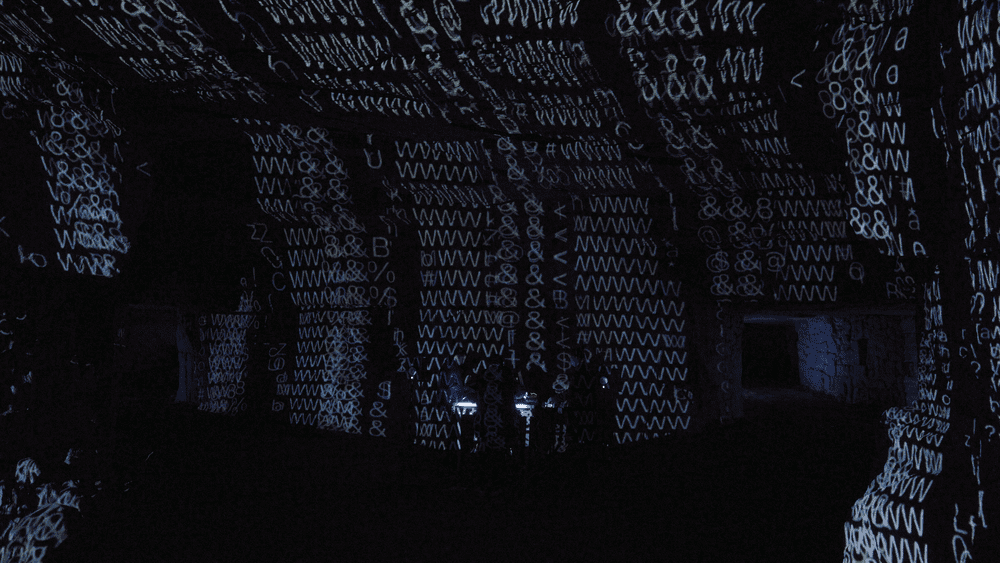

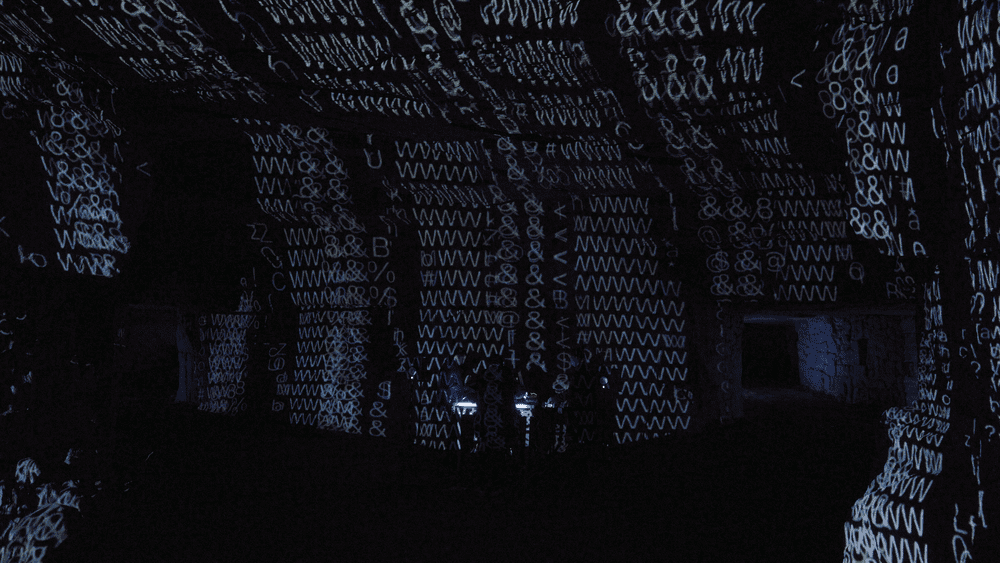

O apresentação Stone Mine Mapping foi projetada para explorar as interações entre som e imagem e para questionar o lugar do espectador. É uma apresentação audiovisual em tempo real na qual a música e a imagem são criadas ao vivo.

Control Random, Maison Sagan e Marin Scart foram movidos pela ideia de uma realização que não poderia ser repetida exatamente duas vezes. Seu desejo coletivo era criar um projeto multidisciplinar que fosse além da experiência e do conhecimento de cada artista. Ao perceberem que estavam cercados por rochas sedimentares, eles queriam questionar o passado, o presente e o futuro desse material, os diferentes estados pelos quais ele havia passado e se projetar em seu futuro. Nessa jornada de cinco partes, os visuais reativos à música são vinculados ao som usando informações de áudio e CV, acionando patches generativos em softwares de criação de imagens.

Os artistas dessa apresentação ao vivo

A música é criada ao vivo pelo Control Random usando um sistema de sintetizador modular Eurorack. Suas composições, em sua maioria executadas ao vivo, podem ser encontradas em seus perfis no Instagram e Bandcamp perfis.

Marin Scart e Neurotypique da Maison Sagan criaram um sistema de geração de imagens composto por uma parte analógica baseada em sintetizadores modulares e uma parte de computador com os softwares TouchDesigner e HeavyM.

Por fim, Jean-Michel Light adicionou luzes controladas por DMX para valorizar melhor o espaço da pedreira.

Na prática: as soluções usadas para os efeitos visuais da apresentação ao vivo

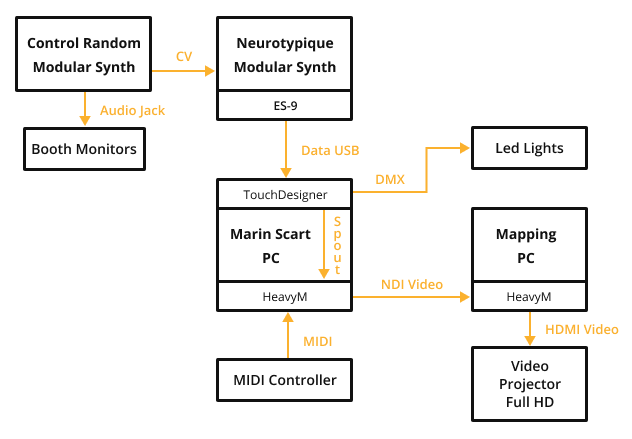

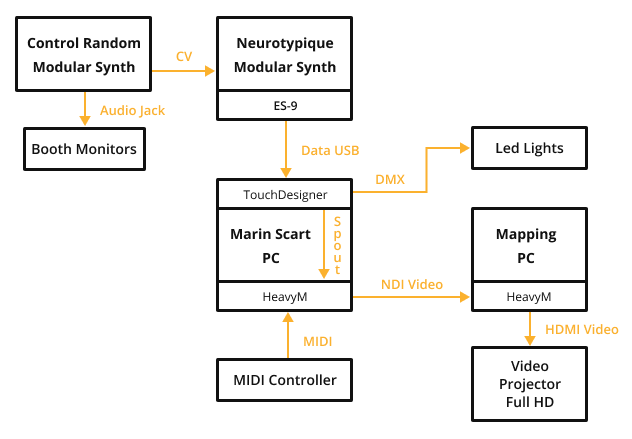

Para criar visuais no ritmo da música, Neurotypique e Marin Scart interconectaram diferentes elementos do sistema. Os sintetizadores modulares do Control Random são instrumentos eletroanalógicos que geram ondas sonoras a partir de osciladores. Os diferentes sinais gerados são enviados aos módulos do Neurotypic, que realizam operações de filtragem e de ligar/desligar. Em seguida, os sinais analógicos são convertidos em sinais digitais para serem interpretados pelo computador de Marin. O TouchDesigner pode gerar efeitos visuais reativos à música, que são modificados com shaders aplicados pelo HeavyM e, por fim, controlados ao vivo com um instrumento MIDI. Por fim, o sinal de vídeo é enviado a um segundo computador que realizará o mapping, ou seja, o posicionamento dos efeitos visuais nas paredes da sala.

Visão geral do sistema de performance ao vivo

A fonte de som: sintetizadores modulares

É um conjunto de módulos independentes em que cada um cumpre uma função fundamental: oscilador, filtro, efeito, etc., de acordo com suas necessidades… As possibilidades de combinação são infinitas e permitem que os artistas produzam músicas exclusivas para eles. Control Random e Neurotypique usaram o sistema Eurorack, que é um formato padrão para sintetizadores modulares. Todos os módulos disponíveis estão listados no site Modular Grid . Há mais de 11.000 deles!

Obviamente, não é necessário usar sintetizadores modulares para criar efeitos visuais em sincronia com a música. Você pode usar qualquer fonte: um mixer de DJ, uma tomada de computador ou até mesmo um microfone.

Computadores

Para manter a taxa de quadros próxima a 60 FPS e evitar qualquer problema de latência durante a apresentação ao vivo, os artistas optaram por usar dois computadores. Essa configuração permite distribuir melhor o processamento e dividir a carga de trabalho entre as máquinas. Outras vantagens dessa solução são que ela permite trabalhar em pares sem interferir uns nos outros e identificar problemas mais facilmente durante a configuração do desempenho.

O computador de efeitos visuais

O computador para o qual as informações de áudio são enviadas é um PC de torre com Windows 10, um processador Intel i7, uma placa de vídeo NVIDIA GeForce GTX 1650 e 16 GB de RAM.

O TouchDesigner e o HeavyM são executados neste computador.

O computador de distorção de imagem

O computador de video mapping, que é usado para ajustar as imagens ao espaço, é um laptop com Windows 10, um processador Intel i5, uma placa de vídeo NVIDIA GeForce GTX 1050 e 8 GB de RAM.

Somente o HeavyM está sendo executado neste computador.

Para obter mais dicas sobre o que procurar em um computador para video mapping, consulte o dedicado a computadores.

O projetor

O projetor usado é um Optoma WU630 Full HD de 6000 lúmens com uma óptica de distância focal curta de proporção 0,9.

Para obter mais dicas sobre como escolher um projetor de vídeo, consulte o artigo dedicado a projetores de vídeo.

Luzes de LED

As luzes usadas para iluminar os túneis nas laterais são Astera Titan Tube com bateria.

Softwares de efeitos audiovisuais responsivos

TouchDesigner

Neurotypique e Marin Scart programaram sua própria composição no software TouchDesigner.

Desenvolvido pela Derivative, o TouchDesigner permite a criação de efeitos visuais em tempo real usando um sistema de programação nodal. O ponto forte do TouchDesigner é o número infinito de combinações possíveis, associado a um tubo gráfico perfeitamente adaptado para apresentações ao vivo. No entanto, é preciso algum tempo para dominá-lo e obter exatamente o que você deseja.

HeavyM

HeavyM é desenvolvido pela Digital Essence e permite que você crie efeitos responsivos de música com apenas alguns cliques. No projeto Stone Mine Mapping, o HeavyM foi usado em dois níveis. O primeiro é o uso de shaders de efeitos de processamento nas saídas de vídeo do TouchDesigner. A segunda é a distorção da imagem geral para se ajustar ao espaço de projeção.

O HeavyM integra diretamente os recursos de análise de áudio para que você possa fazer com que os efeitos visuais reajam à música que está sendo reproduzida. Tudo o que você precisa fazer é conectar o computador a uma fonte de áudio com um cabo jack, por exemplo. Você também pode usar uma placa de som externa.

Comunicação entre os componentes da apresentação

Para gerar visuais responsivos à música, os diferentes elementos de hardware e software devem necessariamente trocar informações.

Os sintetizadores modulares enviam informações de áudio por meio de um módulo específico: os ES-9 Expert Sleepers. Esse é um conversor analógico-digital que converte sinais elétricos em dados digitais que podem ser compreendidos pelo TouchDesigner. Não é necessário ter esse tipo de hardware, pois o HeavyM integra diretamente as funcionalidades de análise de áudio para lhe dar a possibilidade de fazer com que os efeitos visuais reajam à música reproduzida. Tudo o que você precisa fazer é conectar o computador a uma fonte de áudio com um cabo jack, por exemplo. Você também pode usar uma placa de som externa.

Depois que as informações sobre a música são recebidas, o TouchDesigner gera as animações visuais e as envia para o HeavyM com um link Spout . Essa é uma tecnologia que permite enviar a saída de vídeo de um software para outro. O HeavyM recebe o vídeo e, usando um controlador MIDI, o Marin Scart aplica efeitos visuais adicionais. A saída do HeavyM é então enviada para outra instância do HeavyM no segundo computador usando tecnologia NDI. Isso permite que um fluxo de vídeo seja entregue em uma rede com latência mínima. Por fim, o HeavyM modifica a geometria do vídeo para enviá-lo ao projetor de vídeo, que o exibe no espaço da apresentação ao vivo.

Para completar a projeção do vídeo, foram adicionadas luzes de LED nas laterais. Elas combinam com as cores da projeção. Os sinais de controle das luzes são mensagens DMX enviadas por uma rede Wi-Fi do TouchDesigner.

É a sua vez!

A criação de visuais responsivos à música para uma apresentação ao vivo requer algum conhecimento técnico que pode ser facilmente encontrado na Internet. Por outro lado, o hardware necessário se torna cada vez mais acessível, em termos de custo e compreensão. O projeto Stone Mine Mapping pode parecer complexo em um primeiro momento, mas tem a vantagem de fornecer uma visão geral das ferramentas e técnicas disponíveis. É possível considerar um sistema muito mais simples, reduzido a um único computador e alto-falantes. Muitos artistas audiovisuais se contentam em fazer manipulações "pelo ouvido" de acordo com a música que ouvem, sem necessariamente criar um link de áudio e vídeo. Às vezes, o resultado pode ser mais relevante do que deixar o computador decidir sozinho.

Para continuar

Saiba mais sobre projectores

Criámos um guia detalhado para escolher o projector certo para as suas necessidades. Descobrir nossas dicas e erros a serem evitados neste guia que explica as diferentes funcionalidades passo a passo.

Explore o software HeavyM

O HeavyM é um software de video mapping capaz de gerar efeitos visuais e projetá-los em volumes, decorações ou elementos arquitetônicos. O HeavyM é compatível com Mac e Windows.