Wie erstellt man Musikvisualisierungen für Live-Auftritte?

Einige Referenzen für Live-Auftritte

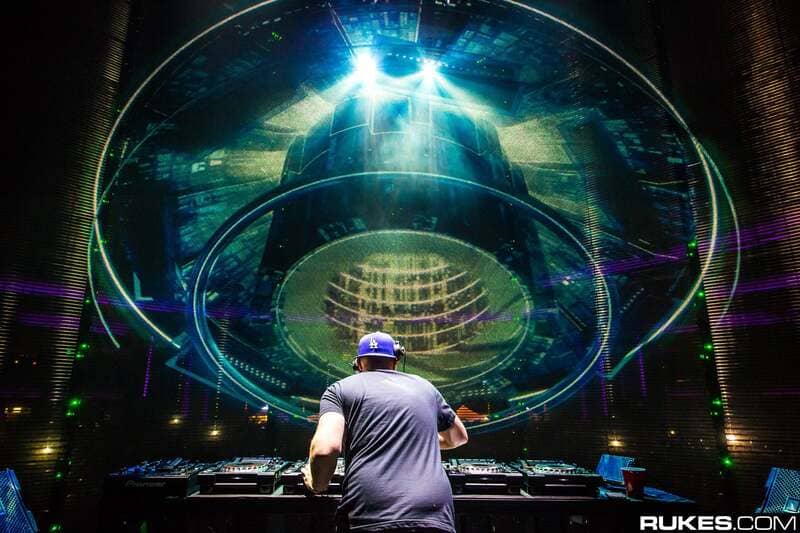

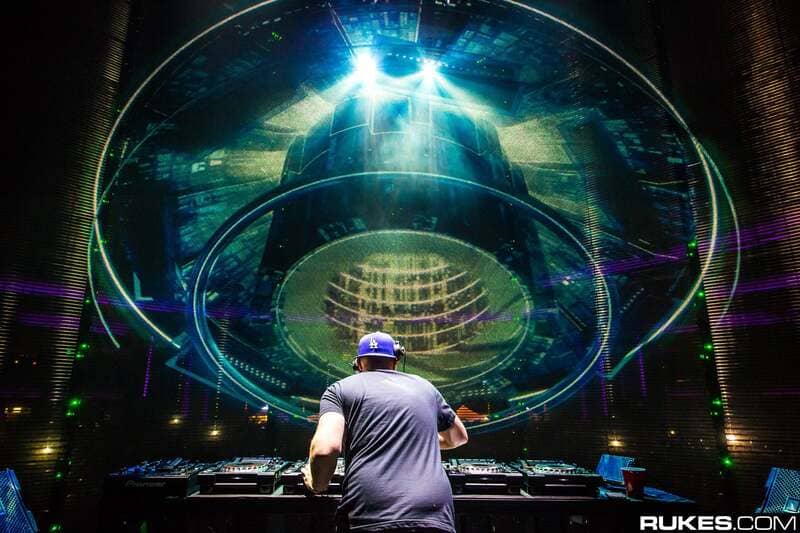

Wenn Sie ein Fan von elektronischer Musik sind, haben Sie wahrscheinlich schon bemerkt, dass immer mehr Künstler und Festivals auf Bühnendekorationen setzen. Sie besteht in der Regel aus festen Bühnenelementen, manchmal gemischt mit Videoprojektionen und LED-Bildschirmen. Veranstaltungen wie Tomorrowland oder Dour Festival sind gute Beispiele dafür. Zu den bekanntesten Künstlern gehören Amon Tobin, Aphex Twin oder Eric Prydz. Sie waren Pioniere in der Verwendung von visuellen Elementen, die auf die Musik auf einer großen Bühne reagieren.

Die Realisierung solcher Aufstellungen erfordert jedoch eine lange Entwicklungszeit und die Zusammenarbeit mit einem engagierten Kreativteam. Die hohe Auflösung der zu manipulierenden Bilder und ihre Fähigkeit, auf die Musik zu reagieren, sind komplexe Probleme, die gelöst werden müssen. Um eine perfekte Synchronisation zwischen Ton und Bild während eines Live-Auftritts zu gewährleisten, müssen die Latenzzeiten so kurz wie möglich sein. Außerdem ist es oft notwendig, mehrere vernetzte Computer zu verwenden und diese zu synchronisieren. Neben den kreativen Fähigkeiten ist auch technisches Know-how gefragt. Alle zu beherrschenden Prozesse lassen sich unter dem Begriff VJ-Technologien zusammenfassen und in Techniken wie Computergrafik, Computerprogrammierung, Audio- und Videosignalverarbeitung, Live-Aufnahmen etc. unterteilt werden.

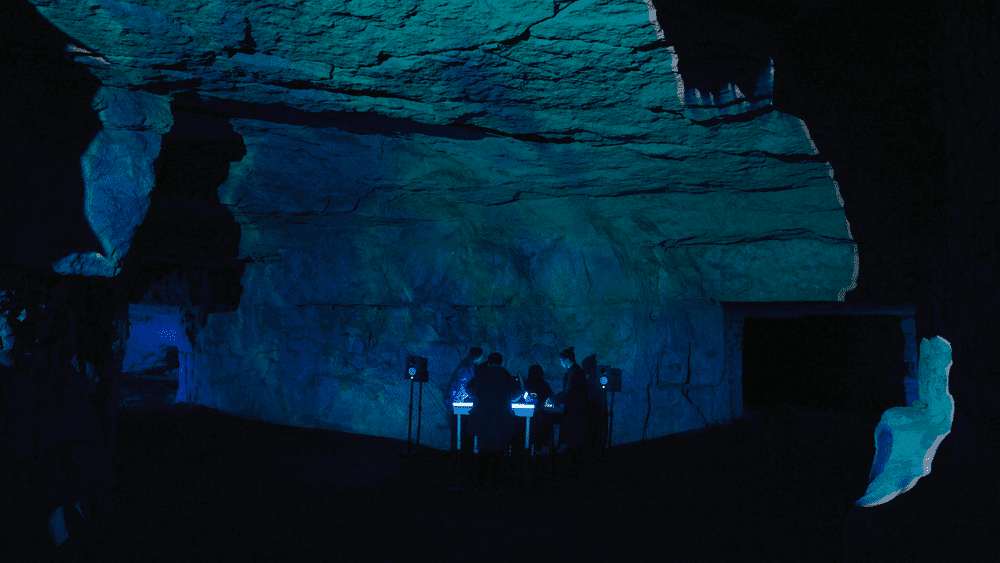

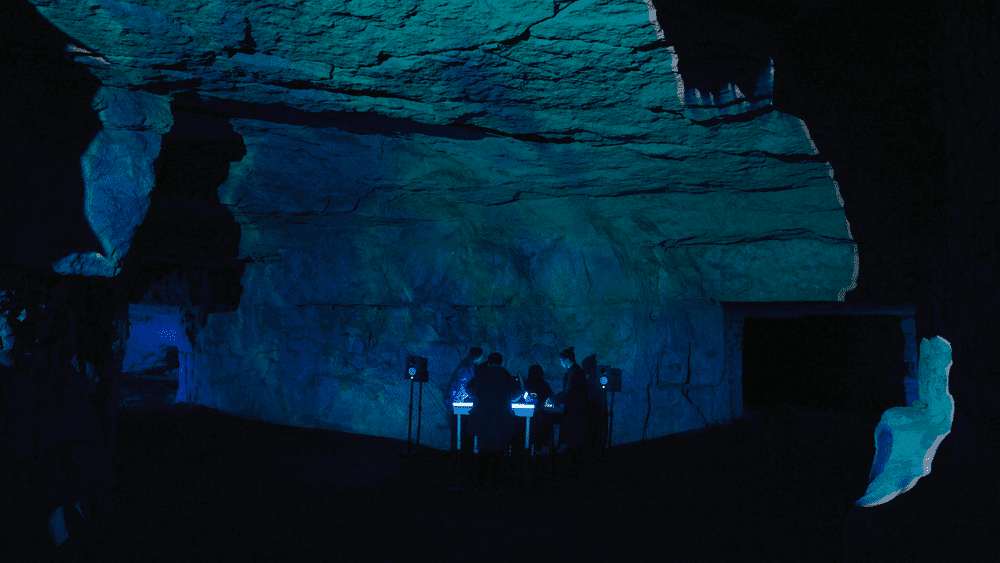

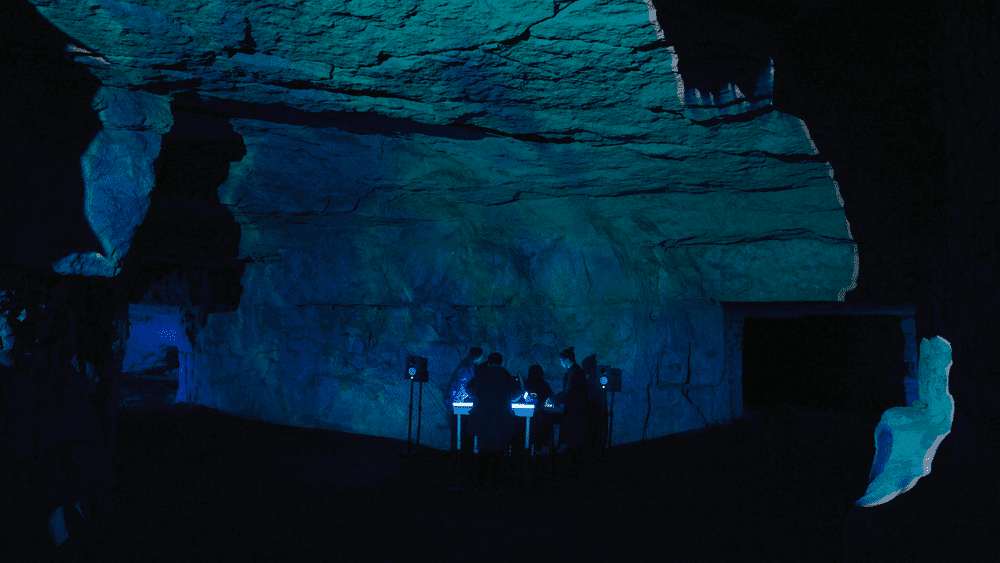

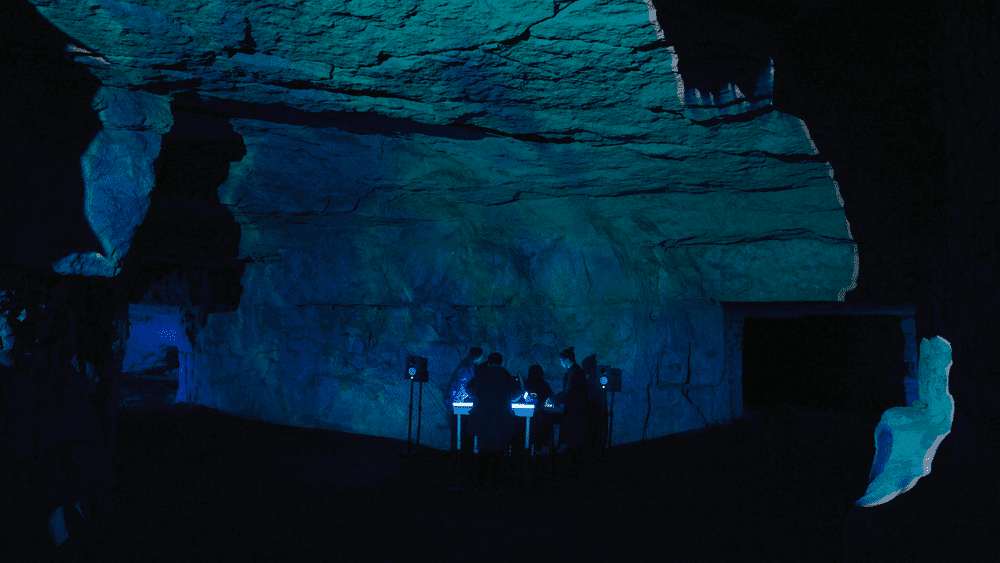

Dieser Artikel soll zeigen, dass die Erstellung von musikgesteuerten visuellen Effekten für kleine bis mittelgroße Bühnenshows nicht so unerreichbar ist, wie man vielleicht denken mag. Mit zugänglicher Software und erschwinglicher Hardware ist es durchaus möglich, einen audiovisuellen Live-Auftritt zu kreieren, ohne wochenlange Arbeit zu investieren. Um dies zu veranschaulichen, stellten die Künstler Control Random, Neurotypique, Marin Scart und Jean-Michel Light die Konzeptionsphasen ihres jüngsten Auftritts in einem Kalksteinbruch vor.

Schwerpunktthemen für visuelle Live-Effekte: FPS und Latenz.

Bei der Erstellung von musikgesteuerten visuellen Effekten für einen Live-Auftritt stehen zwei Punkte im Vordergrund Die Flüssigkeit der visuellen Animationen und der Latenzzeit zwischen Musik und Video.

Es ist unbedingt erforderlich, dass die Bilder mit einer Rate von mindestens 24 Bildern pro Sekunde erzeugt werden . Diese Daten werden als Framerate bezeichnet und in FPS (Frames per Second) ausgedrückt. Unterhalb dieses Wertes, z.B. bei 12 Bildern pro Sekunde, wirken alle Animationen ruckartig. Für schnelle Animationen ist es oft notwendig, einen Wert über 24 FPS anzustreben: 30 oder sogar 60 FPS.

Bei Videospielen mit sehr schnellen Animationen beispielsweise bevorzugen die Spieler die Bildrate gegenüber der Auflösung, um nichts von der Action zu verpassen: 60 FPS in Full HD sind besser als 30 FPS in 4K. Es gibt also einen Kompromiss zwischen besserer Auflösung und besseren FPS.

Je mehr der Computer für ressourcenintensive Verarbeitungen genutzt wird, z. B. für visuelle Effekte oder die gleichzeitige Wiedergabe mehrerer HD-Videos, desto mehr sinkt die FPS-Zahl. Es Es ist in der Regel möglich, die FPS-Zahl über die Einstellungen Ihrer Grafikkarte oder der verwendeten Software anzuzeigen. Es liegt dann an Ihnen, die beste Balance zwischen der Komplexität des Bildmaterials und der FPS-Grenze zu finden, die Sie während Ihres Live-Auftritts nicht unterschreiten sollten.

Latenz ist die Verzögerung zwischen einem Ereignis in der Musik und seiner Auswirkung auf die Bilder. Zum Beispiel möchten Sie jeden "Kick" in der Musik mit einem visuellen Effekt der audio-reaktiven Verzerrung assoziieren. Als Faustregel kann man sagen, dass zwei Ereignisse für den Menschen unmittelbar miteinander verbunden erscheinen, wenn die Verzögerung zwischen ihnen weniger als 100 ms beträgt. Es gibt keine absolute Regel für einen einzuhaltenden Wert, aber eine Verzögerung von mehr als 100 ms gilt als wahrnehmbar. Je niedriger die FPS, desto größer ist die Latenz zwischen den visuellen Effekten und der Musik.

Bei einem Konzert oder einem DJ-Set, bei dem die Musik live gespielt und nicht vorproduziert wird, wird die Musik im Vergleich zu den Bildern immer dominieren. Es ist nicht möglich, sie zu verlangsamen, um sie an die visuellen Animationen anzupassen. Daher müssen sich die Bilder anpassen, um nicht aus dem Takt zu geraten. Entweder reduzieren Sie die aktivierten Effekte, um den Computer nicht zu verlangsamen, oder Sie planen die Verwendung eines leistungsfähigeren Modells.

Eine gängige Technik, die von vielen Videojockeys (VJs) verwendet wird, besteht darin, das System in zwei Teile zu unterteilen: vorgerenderte Videoclips werden abgespielt, gemischt und dann mit visuellen Effekten kombiniert, die auf die Musik reagieren oder nicht und live angewendet werden. Alle verwendeten Videoclips müssen die gleiche FPS haben, damit der VJ ihre Geschwindigkeit an die gespielte Musik anpassen kann.

Ein Beispiel für einen Live-Auftritt mit musikreaktiven Visuals

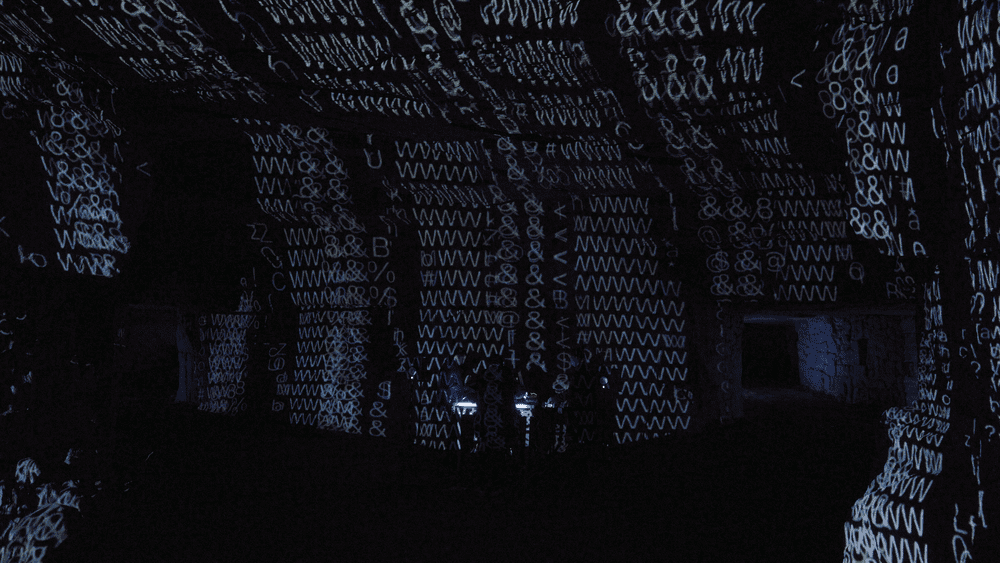

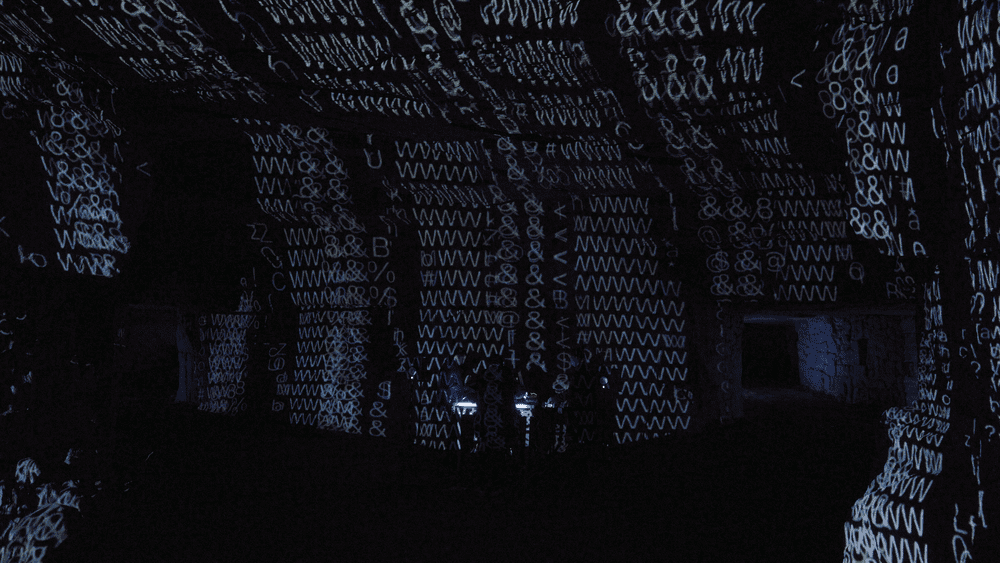

Die Stone Mine Mapping Auftritt wurde entwickelt, um die Wechselwirkungen zwischen Ton und Bild zu erforschen und die Position des Zuschauers zu hinterfragen. Es handelt sich um einen audiovisuellen Echtzeit-Auftritt, bei der Musik und Bilder live generiert werden.

Control Random, Maison Sagan und Marin Scart waren von der Idee inspiriert, etwas zu schaffen, das sich nicht exakt zweimal wiederholen lässt. Ihr gemeinsamer Wunsch war es, ein multidisziplinäres Projekt zu schaffen, das über die Erfahrungen und Kompetenzen der einzelnen Künstler hinausgeht. Im Bewusstsein, von Sedimentgestein umgeben zu sein, wollten sie sich mit der Vergangenheit, der Gegenwart und der Zukunft dieses Materials auseinandersetzen, mit den verschiedenen Zuständen, die es durchlaufen hat, und sich selbst in seine Zukunft projizieren. In dieser fünfteiligen Reise werden Bilder, die auf Musik reagieren, mit Klang verbunden, indem Audio- und CV-Informationen verwendet werden, um generative Patches in Bildbearbeitungsprogrammen zu steuern.

Die Künstler dieses Live-Auftritts

Die Musik wird von Control Random live mit einem modularen Eurorack-Synthesizer-System produziert. Seine Kompositionen, die meist live aufgeführt werden, sind auf seinen Profilen auf Instagram und Bandcamp zu finden.

Marin Scart und Neurotypisch von Maison Sagan haben ein System zur Bildgenerierung entwickelt, das aus einem analogen Teil mit modularen Synthesizern und einem Computerteil mit der Software TouchDesigner und HeavyM-Softwares.

Endlich, Jean-Michel Licht schließlich fügte DMX-gesteuerte Lichter hinzu, um die Räumlichkeit des Steinbruchs besser zur Geltung zu bringen.

In der Praxis: die Lösungen für die visuellen Effekte des Live-Auftritts

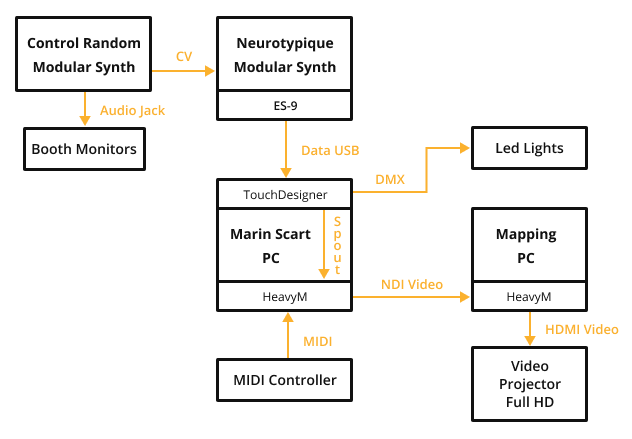

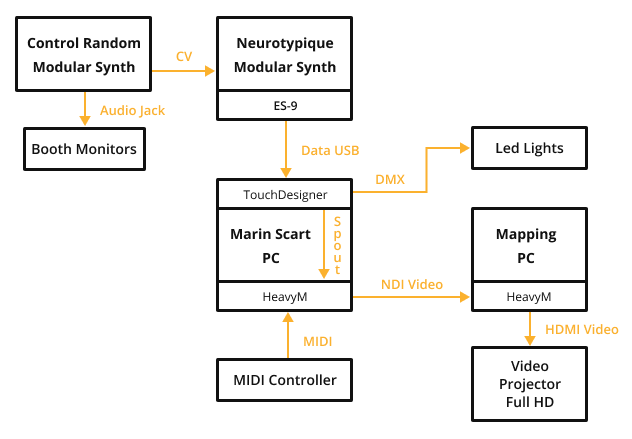

Um visuelle Effekte im Rhythmus der Musik zu erzeugen, haben Neurotypique und Marin Scart verschiedene Elemente des Systems miteinander verbunden. Die modularen Synthesizer von Control Random sind elektroanaloge Instrumente, die aus Oszillatoren Schallwellen erzeugen. Die verschiedenen erzeugten Signale werden an die Module von Neurotypique gesendet, die dann Filter- und Ein-/Ausschaltvorgänge durchführen. Anschließend werden die analogen Signale in digitale Signale umgewandelt, die von Marins Computer interpretiert werden. TouchDesigner kann visuelle Effekte erzeugen, die auf die Musik reagieren. Diese werden dann mit den von HeavyM verwendeten Shadern verändert und schließlich live mit einem MIDI-Instrument gesteuert. Schließlich wird das Videosignal an einen zweiten Computer gesendet, der das Mapping, d.h. die Positionierung der visuellen Effekte auf den Wänden des Raumes, durchführt.

Das Live-Auftritt-System im Überblick

Die Klangquelle: Modulare Synthesizer

Der modulare Synthesizer besteht aus unabhängigen Modulen, von denen jedes eine Grundfunktion erfüllt: Oszillator, Filter, Effekt,... Die Kombinationsmöglichkeiten sind endlos und ermöglichen es dem Künstler, Musik zu produzieren, die einzigartig ist. Control Random und Neurotypique verwenden das Eurorack-System, ein Standardformat für modulare Synthesizer. Alle verfügbaren Module sind auf der Website von Modulares Grid aufgelistet. Es sind mehr als 11.000!

Natürlich ist es nicht notwendig, modulare Synthesizer zu verwenden, um visuelle Effekte passend zur Musik zu erzeugen. Sie können jede beliebige Quelle verwenden: einen DJ-Mixer, einen Computeranschluss oder sogar ein Mikrofon.

Computer

Um die Framerate nahe bei 60 FPS zu halten und Latenzprobleme während der Live-Auftritts zu vermeiden, haben sich die Künstler für den Einsatz von zwei Computern entschieden. Diese Konfiguration ermöglicht es, die Verarbeitung besser zu verteilen und die Arbeitslast zwischen den beiden Computern aufzuteilen. Weitere Vorteile dieser Lösung sind, dass die Künstler zu zweit arbeiten können, ohne sich gegenseitig zu stören, und dass Probleme während des Aufbaus der Auftritt leichter erkannt werden können.

Der Computer für die visuellen Effekte

Der Computer, an den die Audioinformationen gesendet werden, ist ein Tower-PC mit Windows 10, einem Intel i7 Prozessor, einer Nvidia Geforce GTX 1650 Grafikkarte und 16 GB RAM.

Auf diesem Computer laufen Touchdesigner und HeavyM.

Der Video-Mapping-Computer

Der Video-Mapping-Computer, der die Bilder in den Raum einpasst, ist ein Laptop mit Windows 10, einem Intel i5 Prozessor, einer Nvidia Geforce GTX 1050 Grafikkarte und 8 GB RAM.

Auf diesem Computer läuft nur HeavyM.

Weitere Tipps, worauf Sie bei einem Videomapping-Computer achten sollten, finden Sie im entsprechenden Artikel über Computer..

Der Projektor

Der verwendete Projektor ist ein Optoma WU630 mit 6000 Lumen Full HD und einer Kurzdistanzoptik mit einem Verhältnis von 0,9.

Weitere Tipps zur Auswahl eines Videoprojektors finden Sie in unserem Artikel über Videoprojektoren.

LED-Leuchten

Die Lichter, die für die Beleuchtung des Tunnels an den Seiten verwendet werden, sind Astera Titan Tube mit Batterie.

Software für audiovisuelle Effekte

Touchdesigner

Neurotypique und Marin Scart haben ihre eigene Komposition mit der Software Touchdesigner programmiert.

Der von Derivativeentwickelte Touchdesigner ermöglicht die Erstellung von visuellen Effekten in Echtzeit mit Hilfe eines Knotenprogrammiersystems. Die Stärke des Touchdesigners liegt in der unendlichen Anzahl von Kombinationsmöglichkeiten in Verbindung mit einer Grafikpipeline, die perfekt für Live-Auftritts geeignet ist. Es dauert allerdings eine Weile, bis man es beherrscht, um genau das zu bekommen, was man will.

HeavyM

HeavyM wurde von Digital Essence entwickelt und ermöglicht es, mit wenigen Klicks Effekte zu erzeugen, die auf die Musik reagieren. Beim Stone Mine Mapping Projekt wurde HeavyM auf zwei Ebenen eingesetzt. Die erste ist die Verwendung von Shadern, um Effekte auf die Videoausgabe des Touchdesigners anzuwenden. Die zweite ist die Verzerrung des Gesamtbildes, um es an den Projektionsraum anzupassen.

HeavyM integriert direkt Audioanalysefunktionen, um visuelle Effekte auf die abgespielte Musik reagieren zu lassen. Alles, was Sie tun müssen, ist den Computer z.B. über ein Klinkenkabel mit einer Audioquelle zu verbinden. Sie können auch eine externe Soundkarte verwenden.

Kommunikation zwischen den Komponenten

Um musikabhängige Bilder zu erzeugen, müssen die verschiedenen Hard- und Softwareelemente Informationen austauschen.

Modulare Synthesizer senden Audioinformationen über ein spezielles Modul: die ES-9 Expert Sleepers. Dabei handelt es sich um einen Analog-Digital-Wandler, der elektrische Signale in digitale Daten umwandelt, die von Touchdesignern verstanden werden können. Es ist nicht notwendig, diese Art von Hardware zu besitzen, da HeavyM Audioanalysefunktionen direkt integriert, um visuelle Effekte auf die gespielte Musik reagieren zu lassen. Alles, was Sie tun müssen, ist den Computer mit einer Audioquelle zu verbinden, z.B. mit einem Klinkenkabel. Sie können auch eine externe Soundkarte verwenden.

Sobald die Musikinformationen empfangen wurden, erzeugt Touchdesigner die visuellen Animationen und sendet sie über einen Spout Link an HeavyM. Dies ist eine Technologie, die es ermöglicht, die Videoausgabe einer Software an eine andere zu senden. HeavyM empfängt das Video und Marin Scart verwendet einen MIDI-Controller, um zusätzliche visuelle Effekte hinzuzufügen. Die Ausgabe von HeavyM wird dann über die NDI-Technologie, an eine weitere Instanz von HeavyM auf dem zweiten Computer gesendet. Auf diese Weise kann ein Videostream mit minimaler Latenz über ein Netzwerk übertragen werden. Schließlich modifiziert HeavyM die Geometrie des Videos, um es an den Videoprojektor zu senden, der es im Live-Aufführungsraum projiziert.

Um die Videoprojektion zu vervollständigen, wurden an den Seiten LED-Leuchten angebracht. Sie passen sich den Farben der Projektion an. Die Steuersignale für die Lichter sind DMX-Nachrichten, die von Touchdesigner über ein Wifi-Netzwerk gesendet werden.

Jetzt sind Sie dran!

Die Erstellung von musikgesteuerten visuellen Effekten für einen Live-Auftritt erfordert einige technische Kenntnisse, die leicht im Internet zu finden sind. Auf der anderen Seite wird die benötigte Hardware immer erschwinglicher und einfacher zu verstehen. Das Projekt Stone Mine Mapping mag auf den ersten Blick komplex erscheinen, hat aber den Vorteil, dass es einen Überblick über die verfügbaren Tools und Techniken gibt. Man kann sich ein viel einfacheres System vorstellen, das nur aus einem Computer und Lautsprechern besteht. Viele audiovisuelle Künstler begnügen sich damit, Manipulationen "nach Gehör" entsprechend der Musik, die sie hören, vorzunehmen, ohne unbedingt eine Audio-Video-Verbindung herzustellen. Das Ergebnis kann manchmal aussagekräftiger sein, als dem Computer die Entscheidung zu überlassen.

Fortsetzung folgt

Erfahren Sie mehr über Projektoren

Wir haben einen detaillierten Leitfaden zur Auswahl des richtigen Projektors für Ihre Bedürfnisse erstellt. Entdecken Sie unsere Tipps und zu vermeidenden Fehler in diesem Leitfaden, der die verschiedenen Funktionen Schritt für Schritt erklärt.

Entdecken Sie die HeavyM-Software

HeavyM ist eine Video-Mapping-Software, die in der Lage ist Erzeugung visueller Effekte und sie auf Volumen, Dekorationen oder architektonische Elemente zu projizieren. HeavyM ist Kompatibel mit Mac und Windows.